TUMTraf Dataset für die Mobilitätsforschung: Momentaufnahmen, Bildsequenzen und Szenarien von der Providentia++-Teststrecke

Datensätze des Testfelds A9

3,5 Kilometer lang, mit sieben Sensorstationen ausgestattet, die Woche für Woche etwa einen Petabyte komprimierte Daten erheben: Das „Testfeld A9“ erstreckt sich von der Autobahn A9 über die Landstraße B471 bis hinein nach Garching-Hochbrück. Mit über 60 Sensoren wie Flächenkameras, Radaren, Lidaren, Rundumkameras und Event-based Kameras wird im Forschungsprojekt Providentia++ ein breites Spektrum an Sensorik eingesetzt. Deren Daten helfen, KI-basierte Modelle zu trainieren und KI-Netzwerke zu verbessern, Verkehrsverhalten zu analysieren, den Verkehrsfluss zu optimieren, Simulationen für Smart-City-Lösungen zu entwickeln sowie Trackingalgorithmen oder Szenarien zu erforschen.

Aktuelle Releases and Registrierung

Die TUMTraf Datensätze stehen gegen Registrierung zum Download bereit. Bitte REGISTRIEREN SIE SICH HIER. Folgende Datensätze sind aktuell verfügbar:

| Datensatz | Beschreibung |

|---|---|

| R4 | TUMTraf V2X Kooperativer Datensatz. |

| R3 | Synchronisierter Event-Based -und RGB Kamera Datensatz. |

| R2 | Vier Szenarien einer belebten Straßenkreuzung unter verschiedenen Wetterbedingungen mit Daten von zwei Kameras und zwei LiDARs. |

| R1 | Drei unterschiedliche Szenarien von der Autobahn A9 |

| R0 | Multiple Datensätze, die zufällige Sequenzen von Flächenkameras und LiDARen enthalten. |

Informationen zu den Releases

März 2024: Im R4-Release TUMTraf V2X wird ein Datensatz für die kooperative 3D-Objekterkennung und -verfolgung veröffentlicht. Unser Datensatz enthält 2.000 beschriftete Punktwolken und 5.000 beschriftete Bilder von fünf Infrastruktur- und vier Fahrzeugsensoren. Er umfasst 30.000 3D-Boxen mit Track-IDs und präzisen GPS- und IMU-Daten. Wir haben neun Kategorien gekennzeichnet und Verdeckungsszenarien mit herausfordernden Fahrmanövern wie Verkehrsverstößen, Beinaheunfällen, Überholen und Kehrtwenden abgedeckt.

Januar 2024: Im R3-Release TUMTraf Event wird synchronisiertes Bildmaterial zwischen einer Event-Based -und einer RGB Kamera sowie einer kombinierten Darstellung veröffentlicht. Insgesamt enthält der Datensatz über 50.496 2D Bounding Boxen in verschiedenen Verkehrsszenarien bei Tag und bei Nacht. Damit ermöglicht TUMTraf Event u. a. die Erforschung der Datenfusion beider Sensorsysteme im Anwendungsfall einer stationären intelligenten Infrastruktur.

Juni 2023: Im R2-Release liegt der Fokus auf den Verkehr einer belebten Straßenkreuzung, welche wir mit gelabelten LiDAR-Punktewolken und synchronisierten Kamerabildern aufgenommen haben. Die Annotationen liegen als 3D Bounding Boxen mit Track IDs vor. Dieser Release umfasst 4.800 Kamerabilder und Punktewolken, welche mit insgesamt über 57.400 3D-Boxen versehen sind. Hierbei umfasst der Datensatz Objekte aus zehn Klassen, welche komplexe Fahrmanöver, beispielsweise Abbiegemanöver, Überholmanöver oder U-Turns durchführen. Neben dem Datensatz stellen wir auch die Kalibrationsdaten der einzelnen Sensoren zur Verfügung, sodass eine Datenfusion ermöglicht wird. Darüber hinaus möchten wir auf das TUMTraf-Devkit verweisen, welches die Bearbeitung der Daten deutlich erleichtert.

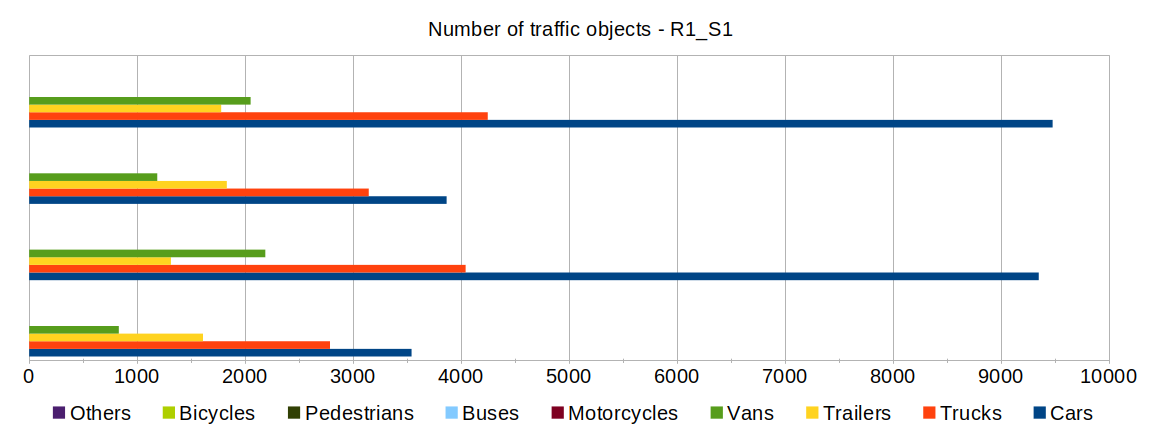

Mai 2022: Das R1-Release besteht aus zeitlich synchronisierten Multi-Sensor-Daten, die von drei verschiedenen Szenarien aufgenommen wurden. Sie enthalten gelabelte „Ground Truth“-Daten von extremen Wettersituationen, die in der Regel im Winter auf der Autobahn vorkommen. Dazu gehören starke Schneefälle kombiniert mit Wind und dichtem Nebel – Szenarien, die Fahrassistenz- und automatisierte Systeme an ihre Grenzen bringen können. Mit diesem Release bieten wir Forschern und Ingenieuren neue „Ground Truth“-Daten von Extremwetter-Situationen, um robuste und wettersichere bildgestützte Systeme entwickeln zu können. Zudem enthält das R1-Release nun eine erweiterte Version des Unfallszenarios, das bereits in der ersten Serie veröffentlichter Datensätze enthalten war. Die Verkehrsentwicklung vor und nach dem Unfall kann nun detaillierter analysiert werden.

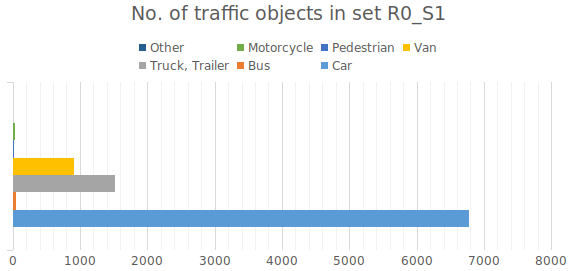

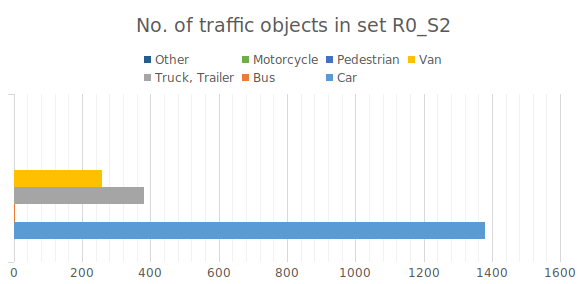

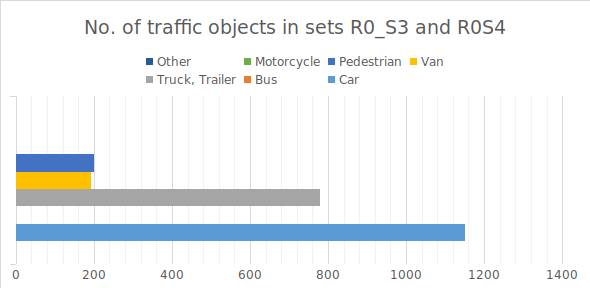

März 2022: Der R0-Datensatz enthält gelabelte Multi-Sensor-Daten mit einem Mix aus zufällig ermittelten Verkehrsszenarien von der Autobahn A9. Diese Datensätze können als „Ground Truth“ für die Entwicklung und Verifizierung von KI-basierten Detektoren sowie Tracking- und Fusionsalgorithmen verwendet werden. Damit helfen sie, die Entstehung und Folgeeffekte von Unfällen auf der Autobahn zu verstehen und zu analysieren.

Näheres zum TUMTraf dev-kit finden Sie unter: https://github.com/tum-traffic-dataset/tum-traffic-dataset-dev-kit.

Roadmap

Weitere Releases werden unter anderem Digital Twins mit Informationen über Trajektorien und Positionen enthalten sowie neue Verkehrsszenarien, längere Sequenzen und Beobachtungen neuer Orte wie beispielsweise einer Kreuzung.

Zitierung

- Release 4: TUMTraf V2X Cooperative Perception Dataset

@inproceedings{zimmer2024tumtrafv2x,

title={TUMTraf V2X Cooperative Perception Dataset},

author={Zimmer, Walter and Wardana, Gerhard Arya and Sritharan, Suren and Zhou,

Xingcheng and Song, Rui and Knoll, Alois C.},

booktitle={2024 IEEE/CVF Conference on Computer Vision and Pattern Recognition, CVPR},

year={2024},

organization={IEEE}

}

- Release 3: TUMTraf Event Dataset

@article{cress2024tumtrafevent,

title={TUMTraf Event: Calibration and Fusion Resulting in a Dataset for Roadside Event-Based and RGB Cameras},

author={Cre{\ss}, Christian and Zimmer, Walter and Purschke, Nils and Doan, Bach Ngoc and Kirchner, Sven

and Lakshminarasimhan, Venkatnarayanan and Strand, Leah and Knoll, Alois C},

journal={arXiv preprint},

url={https://arxiv.org/abs/2401.08474},

year={2024}

}

- Release 2: TUMTraf Intersection Dataset [IEEE Best Student Paper Award]

@inproceedings{zimmer2023tumtrafintersection,

title={TUMTraf Intersection Dataset: All You Need for Urban 3D Camera-LiDAR Roadside Perception},

author={Zimmer, Walter and Cre{\ss}, Christian and Nguyen, Huu Tung and Knoll, Alois C},

booktitle={2023 IEEE 26th International Conference on Intelligent Transportation Systems (ITSC)},

pages={1030--1037},

year={2023},

organization={IEEE}

}

- Release 1: TUMTraf A9 Highway Dataset

@inproceedings{cress2022tumtrafa9,

title={A9-dataset: Multi-sensor infrastructure-based dataset for mobility research},

author={Cre{\ss}, Christian and Zimmer, Walter and Strand, Leah and Fortkord, Maximilian

and Dai, Siyi and Lakshminarasimhan, Venkatnarayanan and Knoll, Alois},

booktitle={2022 IEEE Intelligent Vehicles Symposium (IV)},

pages={965--970},

year={2022},

organization={IEEE}

}

Über Zitierungen unserer Arbeiten würden wir uns sehr freuen.

Release R4 – Kooperativer V2X Datensatz

| Der TUMTraf-V2X-Datensatz enthält zehn verschiedene Szenarien: S01 – S10. Insgesamt wurden 2.000 Punktwolken und 5.000 Bilder von fünf Infrastruktur- und vier Fahrzeugsensoren beschriftet. Er enthält 30.000 beschriftete 3D-Boxen mit Track-IDs und präzisen GPS- und IMU-Daten. Wir haben acht Objektkategorien gekennzeichnet und Verdeckungsszenarien mit herausfordernden Fahrmanövern wie Verkehrsverstößen, Beinaheunfällen, Überholen und Kehrtwenden bei Tag und Nacht abgedeckt. |

| R4_S1 | In diesem Szenario wird das Ego-Fahrzeug von zwei Bussen und zwei großen LKWs verdeckt. Die straßenseitigen Sensoren erweitern die Wahrnehmungsreichweite und machen Verkehrsteilnehmer hinter den Bussen sichtbar. |

| R4_S2 | In diesem Verdeckungsszenario blockiert ein LKW mehrere Fußgänger. Die Straßensensoren können die Objekte hinter dem LKW wahrnehmen, sodass das Ego-Fahrzeug auch diese Objekte erkennen kann. |

| R4_S3 | Bei dieser Fahrt verdeckt ein Bus ein Auto, was von den Straßensensoren erkannt werden kann. |

| R4_S4 | Bei dieser Fahrt führen viele Fahrzeuge ein Kehrtwendemanöver durch und blockieren einige Fußgänger, die an einer roten Ampel warten. |

| R4_S5 | Bei dieser Fahrt behindern mehrere LKWs und Anhänger einige Verkehrsteilnehmer. Diese Verkehrsteilnehmer sind durch die erhöhten Infrastrukturkameras und LiDAR Sensoren sichtbar. |

| R4_S6 | In diesem Szenario verdeckt ein LKW mehrere Objekte, die von der Infrastrukturkamera und dem LiDAR wahrgenommen werden können. |

| R4_S7 | In diesem Beispiel überholt ein Motorradfahrer das Ego-Fahrzeug, das darauf wartet, bis die Fußgänger die Straße überquert haben. |

| R4_S8 | Diese Nachtszene enthält einen Verkehrsverstoß und ist die größte Sequenz im Datensatz. Ein Fußgänger geht über eine rote Ampel, nachdem ein schnell fahrendes Fahrzeug die Kreuzung überquert hat. |

| R4_S9 | In diesem Szenario bremst das Ego-Fahrzeug, um Fußgängern auszuweichen. |

| R4_S10 | Bei dieser Nachtfahrt führt das Ego-Fahrzeug eine Kehrtwende durch. |

Release R3 – Synchronisierter Event-Based -und RGB Kamera Datensatz

| Der Datensatz TUMTraf Event enthält synchronisiertes Bildmaterial von einer Event-Based -und einer RGB Kamera sowie einer kombinierten Darstellung mit 50.496 2D Bounding Boxen. Der Datensatz berücksichtigt verschiedene Verkehrsszenarien bei Tag und bei Nacht. Damit ermöglicht TUMTraf Event u. a. die Erforschung der Datenfusion beider Sensorsysteme im Anwendungsfall einer stationären intelligenten Infrastruktur. Diesbezüglich konnten wir in unserer Arbeit die Stärken beider Sensorsysteme kombinieren und dabei gleichzeitig die Schwächen ausgleichen. Dies führte zu einer spürbaren Reduktion von "False-Positives" bei der RGB Kamera und damit zu einer Steigerung der Erkennungsleistung. Die Ergebnisse sind unten im Video dargestellt: |

Release R2 – Komplexe Verkehrsszenarien an einer belebten Straßenkreuzung

| R2_S1 und R2_S2 | Diese Sequenzen enthalten jeweils 30 Sekunden Verkehrsgeschehen an einer Straßenkreuzung, welche mithilfe von 2 LiDARen und 2 Flächenkameras synchronisiert aufgenommen wurden. Die Aufnahmen wurden am Tag erstellt. Die Objekte sind gelabelt mit 3D-Bounding Boxen sowie eindeutigen Track IDs. So wird eine durchgehende Objektverfolgung ("Tracking") und Datenfusion möglich. |

| R2_S3 | Hingegen zu R2_S1 und R2_S2 enthält diese Sequenz zusammenhängend 120 Sekunden Verkehrsgeschehen an einer Straßenkreuzung, welche ebenfalls von 2 LiDARen und 2 Kameras aufgenommen wurde. Die Aufnahmen wurden am Tag erstellt. Die Objekte sind gelabelt mit 3D-Bounding Boxen sowie eindeutigen Track IDs, welche eine durchgehende Objektverfolgung ("Tracking") und Datenfusion ermöglichen. |

| R2_S4 | Diese Sequenz enthält ebenfalls eine 30 sekündige Aufnahme des Verkehrsgeschehens, welche in einer regnerischen Nacht erstellt wurde. Die Objekte sind wie die anderen Datensätze ebenfalls mit 3D-Bounding Boxen sowie eindeutigen Track IDs gekennzeichnet. |

Release R1 – Verkehrsszenarien von der Autobahn

| R1_S1 | Dieser Datensatz enthält 30 Sekunden lange Multi-Sensor-Sequenzen, die im Winter bei starkem Schneefall aufgenommen wurden. Er besteht aus zeitlich synchronisierten Bildern mit einer Frequenz von 10 fps aus er Perspektive von vier Kameras, die jeweils eine 400 Meter lange Teststrecke von verschiedenen Perspektiven beobachten. Die Verkehrsobjekte sind gelabelt mit 3D-Kästchen ("Bounding Boxes") und eindeutigen IDs in den jeweiligen Sensorframes. So wird eine durchgehende Objektverfolgung ("Tracking") und Datenfusion möglich. |

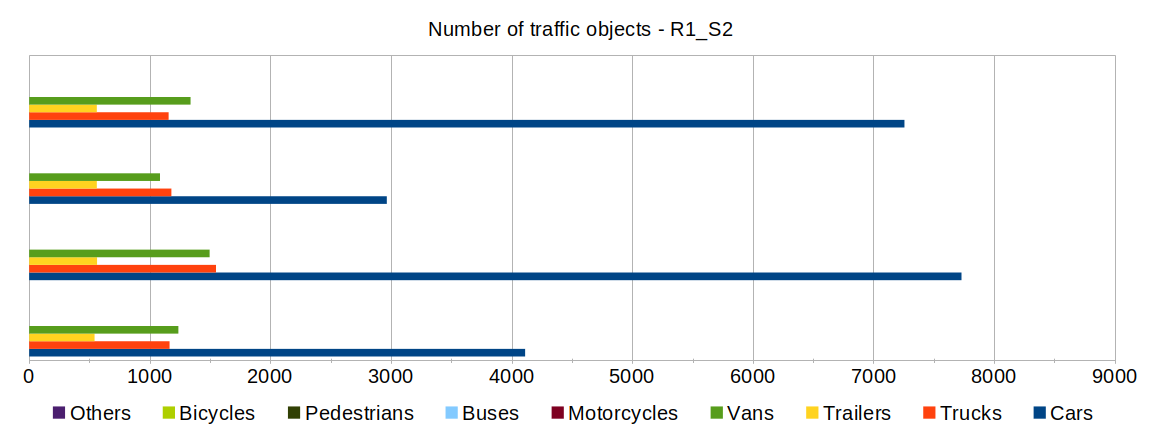

| R1_S2 | Dieser Datensatz enthält 30 Sekunden dauernde Multi-Sensor-Sequenzen, die in starkem Nebel aufgenommen wurden. |

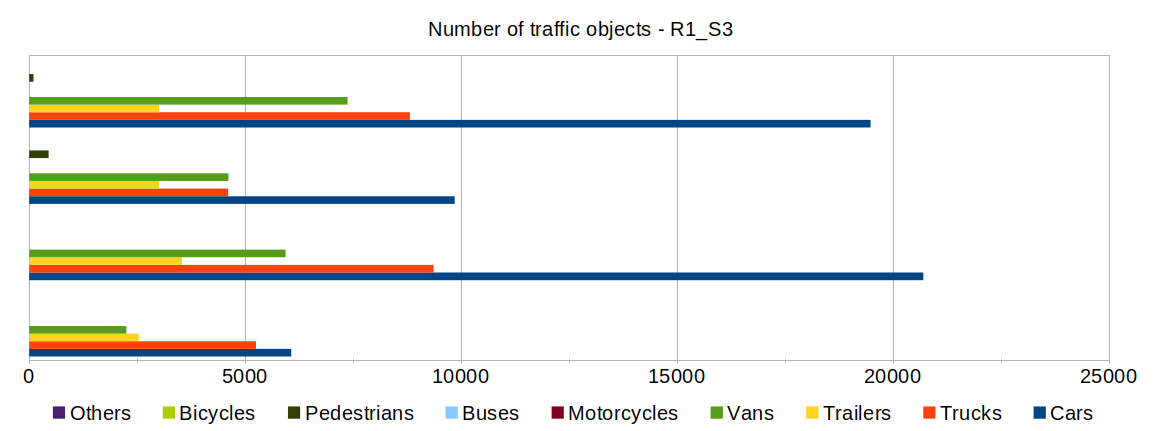

| R1_S3 | Dieser Datensatz enthält eine sechzig Sekunden dauernde Multi-Sensor-Sequenz, die die Zeit vor, während und nach einem Unfall erfasst. |

| R1_S1 | R1_S2 | R1_S3 |

|---|---|---|

|

|

|